Jauno tehnoloģiju jau aktīvi izmanto cilvēki sociālajos tīklos, gan mēģinot atdzīvināt savu radinieku smaidus un galvas kustības, gan arī izmantojot iespēju atgriezties vēl senākā vēsturē, lai aplūkotu, kā savulaik varētu būt izskatījušies Einšteins, Ābrahams Linkolns vai Bēthovens.

Deep Nostalgia by @MyHeritage is a lot of fun. Here are results by Time-Travel Rephotography x Deep Nostalgia.

— Xuan Luo (@XuanLuo14) February 27, 2021

Time-Travel Rephotography: https://t.co/qkUwJ8P2Eb

Deep Nostalgia API: https://t.co/mQSCNDl8dh pic.twitter.com/6ncItlrDVQ

ĪSUMĀ:

- "Deep fake" jeb dziļviltojuma tehnoloģijas pamatā ir mašīnmācīšanās sistēma, kas, analizējot tūkstošiem fotoattēlu un video, spēj patstāvīgi "iemācīties" atpazīt cilvēku sejas un balsi.

- Par dziļviltojumu var kļūt ne tikai video, bet audio faili. Šobrīd mākslīgi veidotus audio failus izmanto spēļu programmēšanā.

- Pastāv risks, ka neīstos video var izmantot ļaunprātīgiem nolūkiem, lai, piemēram, ietekmētu politiskās norises, kādam atriebtos vai izspiestu naudu.

- Lai izveidotu dziļviltojumu, ko grūti atšķirt no īsta, programmai pagaidām nepieciešami tūkstošiem attēlu un video, tomēr šī tehnoloģija turpina strauji attīstīties.

- Mākslīgā intelekta radītie video nav perfekti – acīgākie vērotāji arvien var pamanīt nianses, kas ļauj noteikt to neīstumu.

Viltotās sejas

Nenoliedzami – datoriem arvien labāk izdodas simulēt realitāti. Pēdējos gados īpašu uzmanību izpelnījušās mākslīgā intelekta radītās iespējas. Viena no tām ir mašīnmācīšanās metode, kas ļauj datoriem pārveidot attēlu, video kadros aizstājot personas sejas vaibstus ar cita – līdzīga – cilvēka seju.

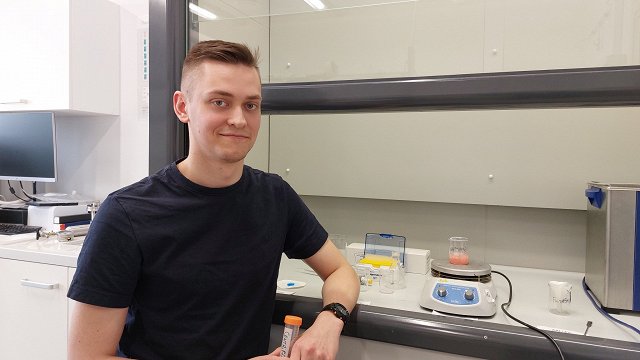

Izmantojot lielu apjomu informācijas, piemēram, tūkstošiem dažādas kvalitātes sejas attēlus vai video no visādiem leņķiem, dziļās mašīnmācīšanās (angļu val. – "deep learning") algoritmi apgūst cilvēka sejas grimases un balss tembru, kas ļauj tehnoloģijai mākslīgi izveidot video un audio saturu.

Kas ir dziļviltojums?

“Deepfake” (no angļu val. – “dziļi viltots”) jeb “dziļviltojuma” tehnoloģija

Vārds “deepfake” ir saliktenis, kas radies no vārdiem “deep learning” – mākslīgā intelekta mašīnmācīšanās veids, ko izmanto šī tehnoloģija, un “fake” – viltots.

Šī tehnoloģija ļauj manipulēt attēlu un video, dažas to daļas reālistiski aizvietojot ar citām, piemēram, nomainot cilvēka seju.

Pirmie "deepfake" jeb dziļviltojumi internetā parādījās 2017. gada nogalē vietnē "Reddit", un kopš tā laika pasauli jau pārsteiguši vairāki plašu atpazīstamību ieguvuši dziļviltojumi, piemēram, video ar Marku Zakerbergu, kurā viņš apgalvo, ka soctīkla "Facebook" patiesais mērķis ir manipulēt ar tā lietotājiem, vai video ar bijušo ASV prezidentu Baraku Obamu, kurā viņš runā par viltus ziņu radītajiem draudiem.

Ir vairākas metodes, kā izveidot dziļviltojumus, bet visbiežāk šim nolūkam tiek izmantoti dziļie neironu tīkli – datorsistēma, kas veidota, iedvesmojoties no dzīvnieku smadzenēs esošā neironu tīkla.

Šī sistēma "iemācās" atpazīt cilvēku sejas. Lai izveidotu dziļviltojumu, jāizvēlas video, kurā atdzīvosies mākslīgi radītais cilvēks, un jāapkopo pēc iespējas vairāk videoklipu, kuros šī persona, kuras seju paredzēts aizstāt, ir redzama. Lai izveidotu dziļviltojumu, var izmantot, piemēram, filmas kadru, un kā avotu neironu tīkla apmācīšanai atlasīt dažādus videoklipus platformā "YouTube".

Neironu tīklu tehnoloģija, izmantojot video, spēj patstāvīgi apgūt to, kā cilvēks izskatās no dažādiem leņķiem dažādos apstākļos.

Pēc tam šī iegūtā informācija tehnoloģijai ļauj "saskatīt" kopīgās iezīmes tā cilvēka sejā, kas redzams video kadrā, kuru plāno izmainīt.

Turklāt jaunākie dziļviltojumi kļūst arvien iespaidīgāki. Piemēram, nesen sociālajā vietnē "TikTok" popularitāti iemantojis neīsts aktiera Toma Krūza profils, kurā redzamie kadri ar slaveno Holivudas personību ir tikai un vienīgi mākslīgā intelekta tehnoloģiju radīts veikums. Šis "TikTok" konts gan tagad jau ir dzēsts.

Šobrīd pieejamas vairākas lietotnes un programmatūras, kas bez īpašas piepūles ļauj izveidot dziļviltojumus, piemēram, "FaceSwap", kas ļauj samainīt vietām sejas fotoattēlos, vai lietotne "DeepFace Lab", kurā var izveidot ne tikai fotoattēlus, bet arī video ar samainītām sejām.

Par dziļviltojumu var kļūt ne tikai video, bet arī audio faili. Dziļās mašīnmācīšanās algoritmi vien dažu stundu vai reizēm pat minūšu laikā var klonēt cilvēka balsi. Tiklīdz balss modelis ir izveidots, šai "personai" var likt sacīt pilnīgi jebko. Šī mākslīgā intelekta radītā balss šobrīd tiek izmantota, piemēram, spēļu programmēšanā – spēļu tēli vairs neseko noteiktam scenārijam, frāzēm, kas ieprogrammētas spēles izstrādes laikā, bet reaģē uz spēlē tobrīd notiekošo.

Klonētās sejas var izmantot ļaunprātīgi

Daudzi eksperti tic, ka līdz ar tehnoloģijas attīstību nākotnē dziļviltojumus atšķirt no īsta attēla kļūs teju neiespējami. Tas rada riskus sabiedrībai un var ietekmēt politiskās norises, kā arī attīstīt kibernoziedzību.

Viena no pirmajām nozarēm, kas aktīvi sāka izmantot dziļviltojumu tehnoloģiju, bija pornogrāfijas industrija. Pētījumu kompānijas "Sensity AI" veiktie pētījumi liecina, ka šādi mākslīgi veidoti pornogrāfiski materiāli, kuros izmantota citas personas seja, kopš 2018. gada decembra veido līdz pat 95% no visiem izveidotajiem dziļviltojumiem, kas pieejami internetā. Turklāt nereti šādi materiāli izveidoti atriebības vai noziedzīgā nolūkā.

Kā liecina šīs pašas kompānijas aplēses, pēdējo gadu laikā dziļviltojumu skaits pieaug ģeometriskā progresijā – no 7964 gadījumiem 2018. gada decembrī līdz 85 047 gadījumiem 2020. gada decembrī.

Dziļviltojumi būtībā ir uzlabots filtrs, kas sejas klona izveidošanai var izmantot arī jūsu sociālajos tīklos ievietotās bildes un video.

Lai izveidotu kvalitatīvu dziļviltojumu, tehnoloģijai gan pagaidām nepieciešami vairāki tūkstoši bilžu un video, tādēļ pašlaik par šīs tehnoloģijas upuriem visbiežāk kļūst politiķi un sabiedrībā labi zināmi cilvēki.

Taču nenoliedzami ir vērts padomāt, cik daudz video un fotoattēlu ar savu vai savu tuvinieku seju mēs ievietojam sociālajos tīklos. Tehnoloģijai attīstoties, pastāv risks, ka nākotnē nelabvēļi arvien biežāk var izmantot dziļviltojumus, lai kādam atriebtos vai sūtītu ziņas ar mērķi izspiest naudu.

Kā atpazīt dziļviltojumu?

Pašreizējos dziļviltojumos ticama sejas atveide vēl nereti sagādā grūtības. Sākotnēji veidotajos video redzamie neīstie cilvēki nemirkšķināja acis vai arī mirkšķināja tās pārāk ātri un nedabiski. 2018. gadā Albānijas Universitātes pētnieki šai problēmai pievērsa uzmanību, tādēļ dziļviltojumu veidotāji šo problēmu nu ir atrisinājuši.

Lielākoties mākslīgajos video redzamajiem cilvēkiem kaut kas nav kārtībā ar ādu vai matiem – šīs ķermeņa daļas šķiet nedaudz izplūdušas. Tāpat nereti arī mulsina video redzamais apgaismojums, kas šķiet īpatnējs un mākslīgs. Tam par iemeslu ir dziļviltojuma izveidošanai izmantotie video materiāli, kuros apgaismojums parasti nesakrīt ar pārveidotajā video esošo.

Pat meistarīgi veidotajos dziļviltojumos, piemēram, kā vienā no vietnē "Tik Tok" redzamajiem video ar Tomu Krūzu, acīgākie vērotāji pamanīja sīkas nianses, kas mākslīgajam intelektam paslīdējušas garām, piemēram, mirklī, kad video uz sekundes simtdaļu izgaist viens no aktiera saules briļļu stikliņiem.

Šobrīd gan ir izveidotas arī programmas, kas atpazīst šādus mākslīgi veidotus video, tomēr pētniekiem no Kalifornijas Universitātes nesen izdevies pierādīt, ka šīs sistēmas iespējams apmānīt.